Advanced Research Group

ご興味・ご関心ございましたら、こちらから

新着記事

IMAGICA GROUP Advanced Research Group(ARG)ではグループ会社のオー・エル・エム・デジタルとともに、2022年度より奈良先端科学技術大学院大学と千葉大学の協力を得て、3D姿勢推定の共同研究を行っています。

現状、舞台やステージにおいてのエフェクト演出は、演者の方がエフェクト発生のタイミングや位置に演技を合わせていることが主流です。本研究では、照明変動・リアルタイム性(低遅延)に対応した姿勢推定を行うことで、演者の動きに合わせたエフェクト演出を可能にすることを目指しております。

ここでは、2024年3月に実施したRED°TOKYO TOWER SKY STADIUMでの実証実験をご報告します。

まずDeep Learningを使った、3D姿勢推定の概要をご説明します。

単眼カメラからのDeep Learningを使った3D姿勢推定は、少し前から様々な事例が報告されています。しかしながら、従来手法は、ライブステージのような激しい光の点滅などによる照明変化への対応や、リアルタイムでの姿勢の出力に課題がありました。

そこでARGでは、研究目標を、以下のように掲げ、ロジックの調査研究から始めました。

研究目標から、カメラも各種カメラ(*1)を用い、最適なカメラを探りました。現時点では、カメラの絞り込みは行わず、各カメラの長所を活かし、研究目標を達成することを前提としています。

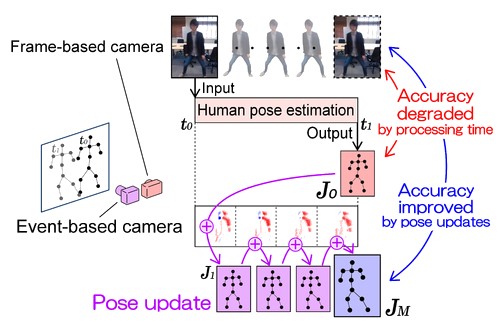

アルゴリズムとしては、SIGGRAPH2023 Postersで発表した技術(*2)をベースとして、姿勢推定器の見直しや、高速化のための各種チューニングを行いました。

2023年3月に、RED°TOKYOのステージに設置されている、各種ムービングライトや、4面の大型LEDウォールを使い、ライブステージに近い環境を構築し、研究のためのデータ取りを行いました。測定したデータを用いて、各事象に有効なカメラの選定や、エラー値を削減するためのアルゴリズムを調整、それらを有機的につなぐプログラムの開発に成功しています。

研究成果を測るため、2024年3月に同じRED°TOKYOにて再度実証実験を行いました。今回は、姿勢をリアルタイムに測定するという一段階上の目標を設定しました。グループ会社のP.I.C.S. TECHに協力を依頼し、測定した結果を基にリアルタイムで生成したエフェクトをLEDウォールに投影してもらいました。ステージ環境としては、各色のムービングライトに加え、LEDウォールへのエフェクト投影、加えてスモークも使用するという、実際のライブステージ演出に近い、むしろ、より厳しいと思われる環境を構築し、実証実験に臨んでいます(会場の照明、エフェクト、ダンサーの踊りなど演出関係はP.I.C.S. TECHに一任しました)。

以下の動画をご覧いただくとおわかりいただけると思いますが、ダンサーは予想以上のトリッキーな動きをしてくださり、1つの作品としても鑑賞できるレベルであり、実践に近い環境であると自負しております。

結果としては、十分に実践で使えるレベルにあると判断をしており、今後も推定精度の向上と処理の高速化を目指し、開発を継続してまいります。

次回のレポートでは、実際のステージで活用した事例をご紹介できればと考えております。

ぜひ、ご期待ください。

プロデュース:ARG

3D姿勢推定:オー・エル・エム・デジタル、奈良先端科学技術大学院大学、千葉大学

リアルタイムエフェクト・演出:P.I.C.S. TECH

*1:RGBカメラ、サーマルカメラ、赤外線カメラ、デプスカメラ、イベントカメラ等

*2:Ippei Otake, Kazuya Kitano, Takahiro Kushida, Hiroyuki Kubo, Akinobu Maejima, Yuki Fujimura, Takuya Funatomi, and Yasuhiro Mukaigawa. Updating Human Pose Estimation using Event-based Camera to Improve Its Accuracy. In ACM SIGGRAPH 2023 Posters (SIGGRAPH ’23). Association for Computing Machinery, New York, NY, USA, Article 37, 1–2. https://doi.org/10.1145/3588028.360368

奈良先端科学技術大学院大学×千葉大学×IMAGICA GROUPインタビュー

視覚×コミュニケーション×AI 最先端の研究分野で化学反応を起こし、まだ誰も見たことのない映像表現を追求